Diese virale Fangfrage entlarvt KI: Warum ChatGPT & Co. einfache Alltagssituationen falsch verstehen

Eine einzige Frage reicht aktuell, um moderne KI bloßzustellen.

Nutzer stellen ChatGPT, Gemini und Perplexity dieselbe Aufgabe – und alle antworten ernsthaft… aber falsch.

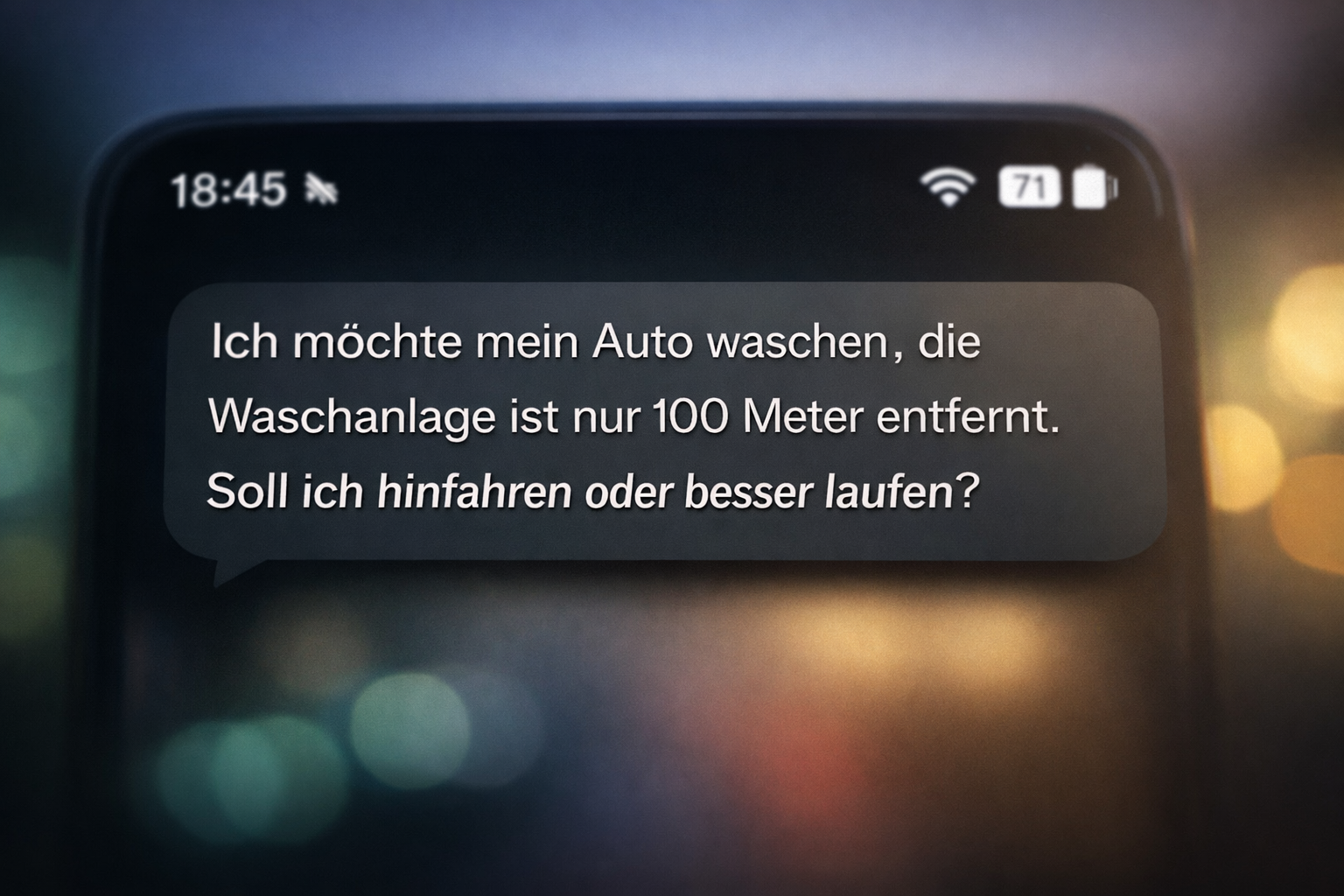

„Die Waschanlage ist 100 Meter entfernt – soll ich hinfahren oder laufen?“

Menschen verstehen sofort den Witz dahinter.

Die KI nicht.

Und genau das zeigt ein grundlegendes Problem moderner künstlicher Intelligenz.

Warum Menschen sofort lachen – und KI nicht

Ein Mensch erkennt die Realität hinter der Frage:

- Das Auto muss sowieso zur Waschanlage

- Also wird es gefahren

- Die Entscheidung betrifft nur die Person

Die sinnvolle Antwort wäre also: Du gehst – das Auto fährt.

KI interpretiert dagegen nur den Wortlaut, nicht die Situation.

Das eigentliche Problem: Es ist keine Wissensfrage

Die Aufgabe prüft nicht Faktenwissen, sondern Alltagsverständnis.

Für Menschen ist das trivial – wir besitzen ein mentales Modell der Welt. Wir wissen, wie Dinge funktionieren, ohne darüber nachzudenken.

Sprachmodelle dagegen erkennen nur Muster in Texten.

Die Frage sieht aus wie eine klassische Entscheidungsfrage → also erzeugt die KI eine Ratgeber-Antwort.

Warum KI hier grundsätzlich scheitert

1. KI berechnet Wahrscheinlichkeit – keine Bedeutung

Sprachmodelle sagen nicht, was logisch ist. Sie sagen, welche Antwort statistisch am besten zu ähnlichen Fragen passt.

Darum erscheinen Antworten plausibel – auch wenn sie inhaltlich danebenliegen.

2. Kein echtes Weltverständnis

Menschen besitzen Kontextwissen:

- Autos fahren nicht ohne Fahrer zur Waschanlage

- Waschen ohne Fahrzeug ist unmöglich

- Die Frage enthält absichtlich eine Denkfalle

KI besitzt dieses Verständnis nicht. Sie simuliert es nur sprachlich.

3. Hilfsmodus statt Zweifel

KI ist darauf trainiert, hilfreich zu wirken. Selbst unsinnige Fragen werden beantwortet statt hinterfragt.

Das Ergebnis nennt man „plausiblen Unsinn“: Eine logisch falsche, aber überzeugend formulierte Antwort.

Warum das gefährlich werden kann

Die Waschstraßen-Frage ist harmlos. Das zugrundeliegende Problem jedoch nicht.

- Medizinische Fragen

- Finanzentscheidungen

- Rechtliche Einschätzungen

- Technische Anleitungen

Wenn KI den Kontext falsch interpretiert, merkt der Nutzer es oft nicht – weil die Antwort kompetent klingt.

Die wichtigste Regel im Umgang mit KI

KI klingt intelligent, denkt aber nicht.

Sie ist ein Muster-Generator, kein Verständnis-System.

Sie kann Wissen strukturieren, Texte formulieren und Ideen liefern – aber sie bewertet Realität nicht zuverlässig.

Fazit

KI kann überzeugend schreiben – aber nicht verstehen.

Und genau deshalb wirken ihre Antworten oft klug, obwohl sie falsch sind.

Die Waschstraßen-Frage ist nur ein Meme.

Die Konsequenzen im echten Leben sind es nicht.